1989年,卡内基梅隆大学接到了美国军方的一个研究课题,内容是那时看起来不能思议的自动驾驶。

为此,研究职员给一辆翻新的军用抢救车,装上了一个看起来像探照灯的硕大摄像头,还配备了一台冰箱巨细的处置器和一部5000W的发电机。

只管装备简陋、数据粗拙,好比据媒体报道那时车顶的摄像头只能输入30×32像素网格,但借助开创性的神经网络,这辆名为ALVINN的自动驾驶汽车最高速率能到达88km/h。

ALVINN被誉为自动驾驶领域一个里程碑项目。其最深刻的影响,正是用神经网络替换人工代码,成为厥后自动驾驶手艺生长的一座灯塔。

今后数十年,自动驾驶手艺沿着ALVINN的偏向飞速生长,直到chatGPT问世,大模子走上舞台,成为改变自动驾驶*的一个变量。

在车端,大模子已经作用于自动驾驶的感知和展望环节,正在向决议层渗透;在云端,大模子为L3及以上自动驾驶落地铺平了蹊径;甚至,大模子还将加速都会NOA落地。

而全球的下游企业中,特斯拉毫无疑问是跑在最前面的少数。

今年8月特斯拉端到端AI自动驾驶系统FSD Beta V12版本的果然亮相,据称可以完全依赖车载摄像头和神经网络,识别蹊径和交通情形并做出响应的决议。

这种端到端模子的感知决议一体化,让自动驾驶直接从一端输入图像数据,一端输出操作控制,更靠近人类的真实驾驶。

但车企们起劲靠近端到端模子时才发现,想要逾越必须先追随。

01 算法优先

让大模子上车,特斯拉*是最激进的一个。

早在2015年,特斯拉就最先结构自动驾驶软硬件自研,2016-2019年陆续实现了算法和芯片自研。随后在2020年,特斯拉自动驾驶又迎来大规模升级:

不仅用FSD Beta替换了Mobileye的Autopilot 3.0,还将算法由原来的2D CNN升级为BEV Transform。

Transformer就是GPT中的T,是一种深度学习神经网络,优势是可实现全局明晰的特征提取,增强模子稳固性和泛化能力。

BEV全称是Bird’s Eye View(鸟瞰视角),是一种将三维环境信息投影到二维平面的方式,以俯视视角展示环境当中的物体和地形。

与传统小模子相比,BEV Transformer对智能驾驶的感知和泛化能力举行了提升,有助于缓解智能驾驶的长尾问题:

1)感知能力:BEV统一视角,将激光雷达、雷达和相机等多模态数据融合至统一平面上,可以提供全局视角并消除数据之间的遮挡和重叠问题,提高物体检测和跟踪的精度 ;

2)泛化能力:Transformer模子通过自注重力机制,可实现全局明晰的特征提取,有利于寻找事物自己的内在关系,使智能驾驶学会总结归纳而不是机械式学习。

2022年特斯拉又在算法中引入时序网络,并将BEV升级为占用网络(OccupancyNetwork),有用解决了从三维到二维历程中的信息损失问题。

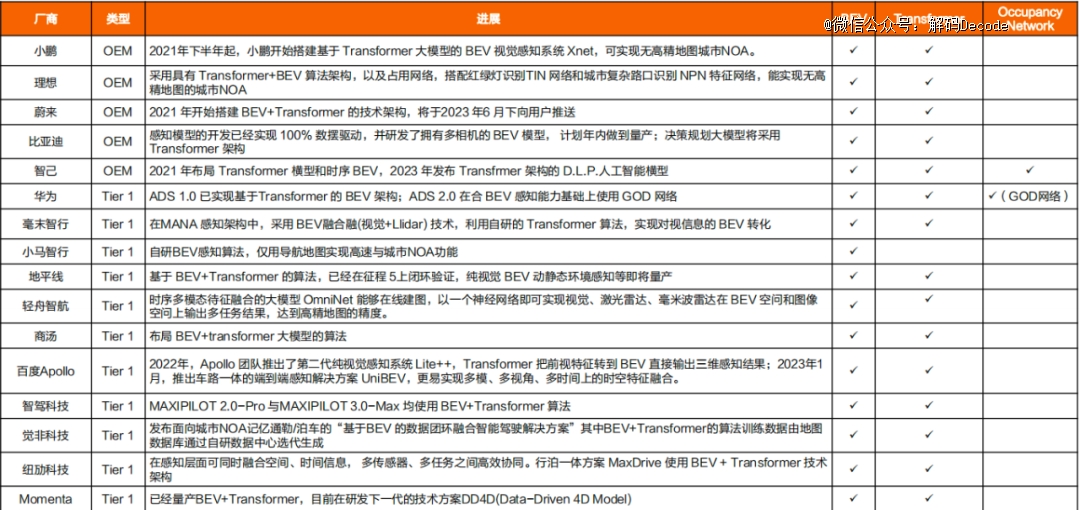

从感知算法的推进来看,行业总体2022年及之前的的商业化应用主要为2D CNN算法。随着ChatGPT等AI大模子的兴起,算法已经升级至BEV Transformer。

时间上特斯拉有*优势(2020年),海内小鹏、华为、理想等均是今年才切换至BEV Transformer。

但岂论是特斯拉照样海内主机厂,BEV Transformer都仍只应用于感知端。

虽然学术界以最终计划为目的,提出感知决议一体化的智能驾驶通用大模子UniAD 全栈Transformer模子,不外受限于算法庞大性 大算力要求,目的落地尚无准确时间表。

02 算力竞赛

2016年,因辅助驾驶致死事故和Mobileye分道扬镳的特斯拉,找到英伟达定制了算力为24TOPS的盘算平台 Drive PX2,由此开启了车企疯狂追求算力的神奇序幕。

继Drive PX2之后,英伟达在6年时间内公布了三代智能驾驶芯片,从Xavier、Orin再到Thor,算力从30TOPS一跃升到2000TOPS,足足增进了83倍,比摩尔定律还要快。

上游云云“丧心病狂”的堆算力,归根结底照样由于下游有人买单。

一方面,随着智能汽车上的传感器规格和数目提升,带来数据层面的暴涨。

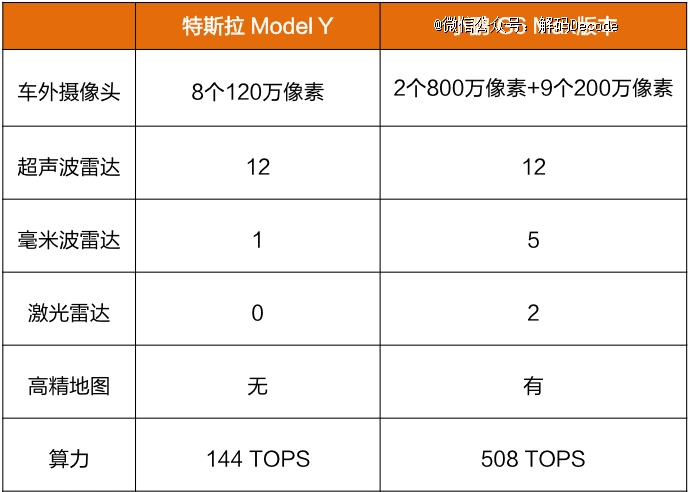

以特斯拉Model Y和小鹏 G6 Max为例,后者因设置了更多传感器,所需算力到达了前者的3.5倍。

当一辆自动驾驶车辆天天可以发生数TB,甚至数十TB数据,数据处置能力即为自动驾驶手艺验证的要害点之一。

另一方面,“大模子化”也让智能驾驶算法的芯片算力愈发吃紧。

上汽人工智能实验室曾测试,实现L2级自动驾驶只需10Tops以下的算力,即即是实现L4级自动驾驶也只需100Tops左右的算力。而下游企业暴涨的算力需求,现实也尚有缘故原由。

阿里罗汉堂选择了「六便士」

一个是云端算力。

自动驾驶系统前期和后期开发依赖大量环境数据输入,对算法举行训练与验证,同时仿真测试中场景搭建与渲染也需要高算力支持。

而且特斯拉引领的神经网络Transformer又是一个资源消耗大户,毫末智行数据显示,Transformer在训练端所需算力是CNN的100倍。

云云一来,下游企业想要获得算力要么自建智算中央(特斯拉),要么与云服务商相助,最不济的所有外采,包罗算法、盘算资源、应用服务等。

海内主流主机厂/自动驾驶厂商的智算中央虽然都已上线,但因自建成本较高,海内主流自动驾驶厂商大多接纳相助模式/采购模式,好比祥瑞星睿、小鹏扶摇都是阿里云,毫末和理想则是火山引擎。但从耐久成本优势来看,仍具备较高的自建倾向。

尚有一个则是NOA。

现实中主机厂具备都会NOA高阶智能驾驶功效的车型,算力大多在200-500TOPS左右。

但NOA从高速蹊径向都会蹊径拓展(高速蹊径-都会快速路-都会主干道-都会次干道-都会支路)的历程中,人流越麋集(天天仅25%的人出行途径高速,而都会蹊径则是100%)的蹊径环境庞漂亮更高,物体识别、感知融合和系统决议的算力需求就越高。

沐曦首席产物官孙国梁就指出,在车端部署大模子并能实现既定义务,算力至少要到达300~500TOPS。模子优化或可降低算力要求,但思量到未来场景庞漂亮和数据量增添,以及视觉感知占比增添(相对基于规则),车端算力或将翻倍达800TOPS以上。

03 感知升级

光大证券有一个判断,以为L2/L2 级向L3级高阶智能驾驶迈进的三概略素主要性排序划分是数据>算法>硬件,尔后阶段向更高阶智能驾驶迈进的排序或为硬件>=算法>数据。

理论依据在于,实现L3级智能驾驶的要害在于周全感知,主要依赖海量 长尾场景数据驱动算法升级优化;其中,无图场景笼罩还需低线都会数据(vs.当前车载算力已基本知足L3-L4级需求)。

而当前阶段,海量 长尾场景数据的获取就要依赖车载传感器(摄像头)的大幅升级。

凭证Yole讲述,自动驾驶L1-L3所需的摄像头数目翻倍增进,好比L1-L2级仅需前后两颗摄像头,到L3就要20颗。

而现实上,主机厂为后续OTA升级预留冗余,单车摄像头设置远超本级所需的摄像头数目,如特斯拉Model 3搭载9颗,蔚来、小鹏、理想车型到达10-13颗。

此外,因大模子对感知数据的精致化要求,高分辨率图像数据可以作为深度学习模子中更新和优化其架构的参数的数据源,尤其是前视摄像头,需要解决的场景最多,目的识别义务最庞大,好比远距离小目的识别、近距离目的切入识别。

为了对更远距离的目的举行识别和监测,车载摄像头就要向800万像素或更高升级。典型如百度Apollo,就已团结索尼、联创与黑芝麻智能,全球首创了超1500万高像素车载摄像头模组。

而在提高感知能力这件事上,尚有两个所有车企都想绕开的坎,高精舆图和激光雷达。

高精度舆图作为先验信息,可以给自动驾驶提供大量的平安冗余,在数据和算法尚未成熟之前,主机厂依赖水平较高。而脱图的缘故原由也对照好明晰:

1)高精舆图存在更新周期长、成本高、图商资格收紧等坏处,限制了高阶自动驾驶大规模商业化的可能性。

2)构建数据闭环,形成对算法模子的迭代升级反哺车端。

至于若何脱图,特斯拉的设施是引入车道线网络及新的数据标注方式,海内自动驾驶头部公司则接纳车端实时建图方案,通过安装在车辆上的相机等传感器来构建车辆行驶历程中周围的环田舆图。

现在小鹏、华为等头部主机厂公布无高精舆图的高阶智能驾驶方案,并定下量产时间表,华为、毫末、元戎启行等自动驾驶公司也加入其中,自动驾驶算法“重感知,轻舆图”趋势明确。

激光雷达则是由于成本问题。

激光雷达在距离和空间信息方面具有精度优势,搭载激光雷达的多传感器融合感知方案可通过互补到达全环境感知能力,为高级别自动驾驶提供平安冗余。

但激光雷达也简直是成本大户,早些年除了特斯拉,险些所有成熟的无人驾驶手艺方案都接纳了64位激光雷达,它的成本约人民币70万元,一个小雷达抵得上一辆车甚至几辆车。

特斯拉行使占用网络来实现类似激光雷达的感知效果,海内主机厂由于机械视觉算法的缺失,预计仍将激光雷达作为主要的弥补传感器,由此可削减在视觉领域所需积累的数据量。

另外4D成像毫米波雷达或将完全替换3D毫米波雷达,有望对低线激光雷达形成替换。

与激光雷达相比,4D成像毫米波雷达部门指标近似到达16线激光雷达性能,但成本仅为激光雷达十分之一。

特斯拉基于全新的自动驾驶硬件HW4.0,首次在S/X的车型上搭载了4D毫米波雷达。除特斯拉外,价钱在40万元以下的理想车型和价钱在70万以上的宝马车型、以及通用收购的Cruise自动驾驶服务车均于近两年完成了4D毫米波雷达结构。同时大陆、采埃孚等汽车Tier-1巨头基本完成对该领域的结构。

04 尾声

8月,马斯克亲自上线开启了一场FSD Beta V12的试驾直播,45分钟内FSD Beta V12系统在行驶全程希望异常顺遂,能够轻松绕过障碍物,识别蹊径种种标志。

马斯克激动地示意:

V12系统重新到尾都是通过AI实现。我们没有编程,没有程序员写一行代码来识别蹊径、行人等,所有交给了神经网络。

而这一切是确立在巨量的「视频数据」和1万个H100之上。

遗憾的是,这两个战略性资源都不是海内主机厂能够容易追遇上的。